あけましておめでとうございます。

タイトルの通りなのですが私のやっていた会社、株式会社マイニングブラウニーは2015年1月1日から株式会社オークファンの100%子会社となりました。

プレスリリース

自分の作った会社だったので、退職とはちょっと違いますが、一つの区切りとして、書いておきたいと思いました。

とりあえず恒例のほしい物リストを

http://www.amazon.co.jp/gp/registry/wishlist/3AYKVKHE1C52X

経緯

この話をしはじめたのは、そんなに前の事ではありませんでした。

資金調達を考えて、証券会社の人とお話をしたら、その数分後にオークファンの武永社長から情報交換でもどうですか?というお話が直接ありました。

証券会社の仕事が早すぎるなと思っていたら、本当に偶然声をかけてくれたようです。

今後3年間で私がやりたい事をお話し、オークファンの今後やっていこうとしていることをお聞きしました。

その中で、やろうとしていることが非常に重なっている部分が多く少しワクワクしたのを覚えています。

それからの数ヶ月間は色々悩みながらも、何人かのオークファンのメンバーともお話していく中で徐々に期待に変わっていきました。

2014年に何を考えていたのか

話は少し戻って、2014年という1年に何を考えていたのか。

株式会社マイニングブラウニーという会社は前身の米国法人も含めると9年3ヶ月やっていたわけですが、

その間データをいかに有効に使っていくのかというのを考えてきました。

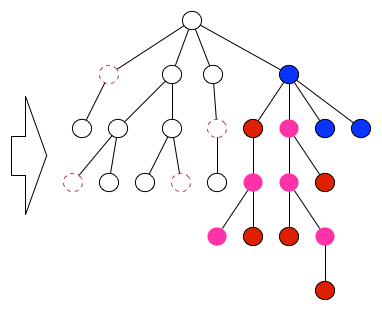

考えた中で、自分の中でしっくりきた考えかたとして、幾つかのフェーズによって分類し、キチンと回転させる事が大切だと考えてました。

この円はデータの活用において必要なフェーズを6つに分けたものです。

今までデータを扱うのに指標がなかったため、ビッグデータという言葉がひとり歩きし、

うまく活用できていない企業を見てきました。

データがなかったり、整理できていなかったり、分析できていなかったり。

そんな中、2014年にはビッグデータが幻滅期に入り、やっと過度な期待がなくなり正当な評価をしだしたと感じ始めました。

先進テクノロジのハイプ・サイクル: 2014年

出典: ガートナー (2014年8月)

2015年にはこのチャンスを活かしたいと思っていました。

そこで資金調達を考えはじめたのです。

ここで冒頭の証券会社との話になります。

ビッグデータへの幻滅と同じくして、IoTが騒がれるようになってきました。

正直なところ私はそんなにIoTには興味がないのですが、IoTによってビッグデータが早期に幻滅期を抜ける可能性があることに期待しています。

それはIoTによって莫大な量のデータが手に入るようになり、機械的に処理する必要が出てくる事になってくるそんな時代が見えたからです。

今後3年間で可視化、活用する部分を強化していくことも考えましたが、その場合どうしてもスピード感が足りないと感じていました。

であれば、分析の部分にリソースを集中しようと。

そこでデータの分析について調べ、考えました。

分析について

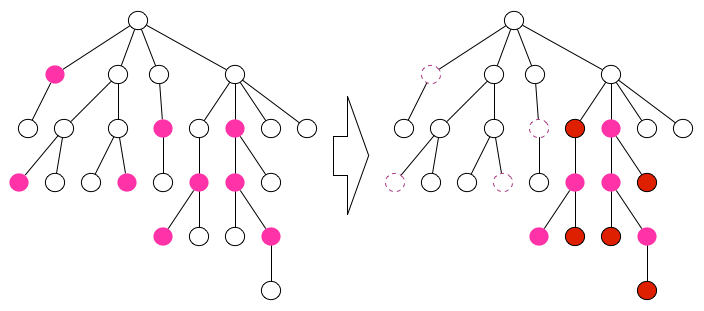

いわゆる分析と言っても、いくつかの段階に別れます。

今の段階では、私は

- Reporting

- Analysis

- Monitoring

- Prediction

この4段階に分けたいと思います。

今後、ルールを決めるとかそういったことが分析の中に組み込まれていくような気がします。

Reporting

まずもっとも簡単で価値を得られるものとして、データから過去を知る事です。

過去を知ると言うのは何が起こったかを知ることです。

例えば、飲食店であれば、12時には食事がよく出るけど、15時にはコーヒーが良くでる。といったことがわかります。

たいてい現場の人間からすると知ってたというようなものがほとんどだったりします。

先ほどの6つのフェーズでいうと、分析というよりもどちらかと言うと整理と可視化に近いです。

Analysis

次に、過去に起こったことの理由を知ることです。

飲食店でいうと、12時はランチの時間だし、15時はティータイムという理由付けになります。

いわゆるBIと呼ばれる領域では、この過去に起こったことの理由を探るのに、

人間の外部知識が必要だったりします。

これを機械がやろうとすると、途端に難しくなります。

レジのデータだけでなく、別のデータが必要になってくる可能性もあります。

Monitoring

モニタリングなんて、さっきの理由を知ることに比べたら簡単じゃないかと思われるかもしれませんが、

ここでいう

モニタリングと言うのは、リアルタイムに物事を知ることにとどまらないと考えます。

例えば、クレジットカードを利用した時に、その利用が不正なのか、不正ではないのか

そういったことを検知してこそのMonitoringです。

リアルタイムで人間が見ることを求めていません。リアルタイムで、機械が判断することを求めます。

ここに来ると、確実に機械学習が必要になります。

Prediction

最後にPrediction。未来の予測です。

飲食店でいうと客足予測、注文予測などがこの領域に入ってきます。

機械学習だけでなく、

人工知能の他の研究範囲の技術も必要になって来ることもありますが、2015年以降はここに力を入れていきます。

2015年以降

前述のとおり、マイニングブラウニーとしてこれからPredictionに力を入れていきたいと思っていたところ、オークファンの今後の計画とぴったりとフィットし、一緒にやっていきたいという気持ちになりました。

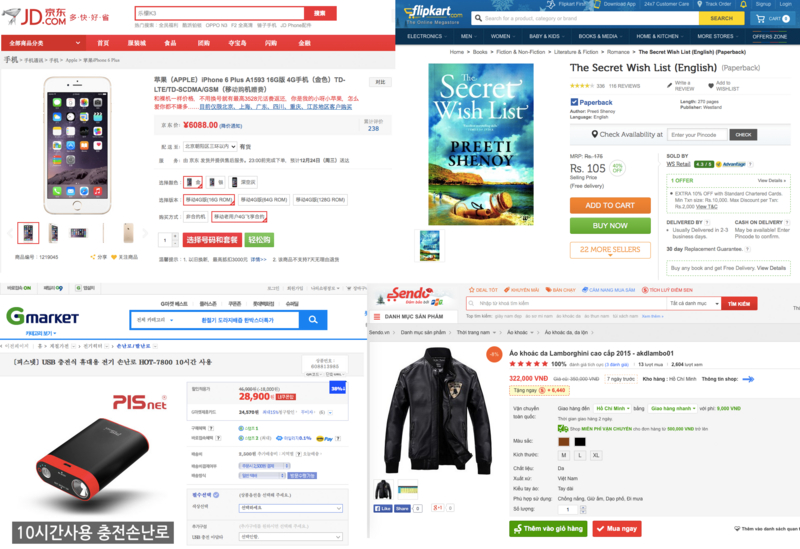

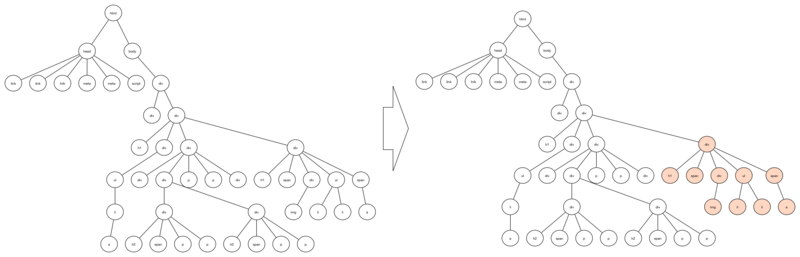

ちなみに、オークファンの考えるデータの活用に関しての図はプレスリリースに載っている画像の通りで、

- Data

- Infomation

- Presentation

- Solution

の4つに分類しています。

これを先ほどの6つのフェーズに重ねると以下の図のようになります。

そして、オークファンは既にaucfanや、valuefanといったPresentationを展開しています。

また、Solutionについても、力をいれています。

マイニングブラウニーは創業時から要素技術でやっていくと決めていたので、DataとInfomationをサービスとして展開しています。

私はオークファンでDataとInfomationの部分を担当します。

今回の子会社化により、4つの領域すべてに力を入れられることになります。

この4つの領域が噛み合ってビジネスを展開出来る今、数年後が楽しみで仕方ありません。

さいごに

今回の子会社化にあたって、たくさんの人の協力がありました。

また、マイニングブラウニーという会社も私自身も9年間の間で沢山の人と知り合い、色々なことを経験させてもらったお陰で、今回のようなタッグが実現したと思います。

この場にてお礼を申し上げたいと思います。

これからもオークファンとしての私もよろしくお願い致します。